DN-redaktören om AI-tekniken som kan skapa falska bilder: ”Det är verkligen häpnadsväckande vad fort det har gått”

Det kommer allt fler AI-verktyg som kan generera verklighetstrogna bilder genom några få klick. Linus Larsson, techredaktör på Dagens Nyheter, menar att det här är en påminnelse om hur vi bör förhålla oss till bilder som sanningsbärare.

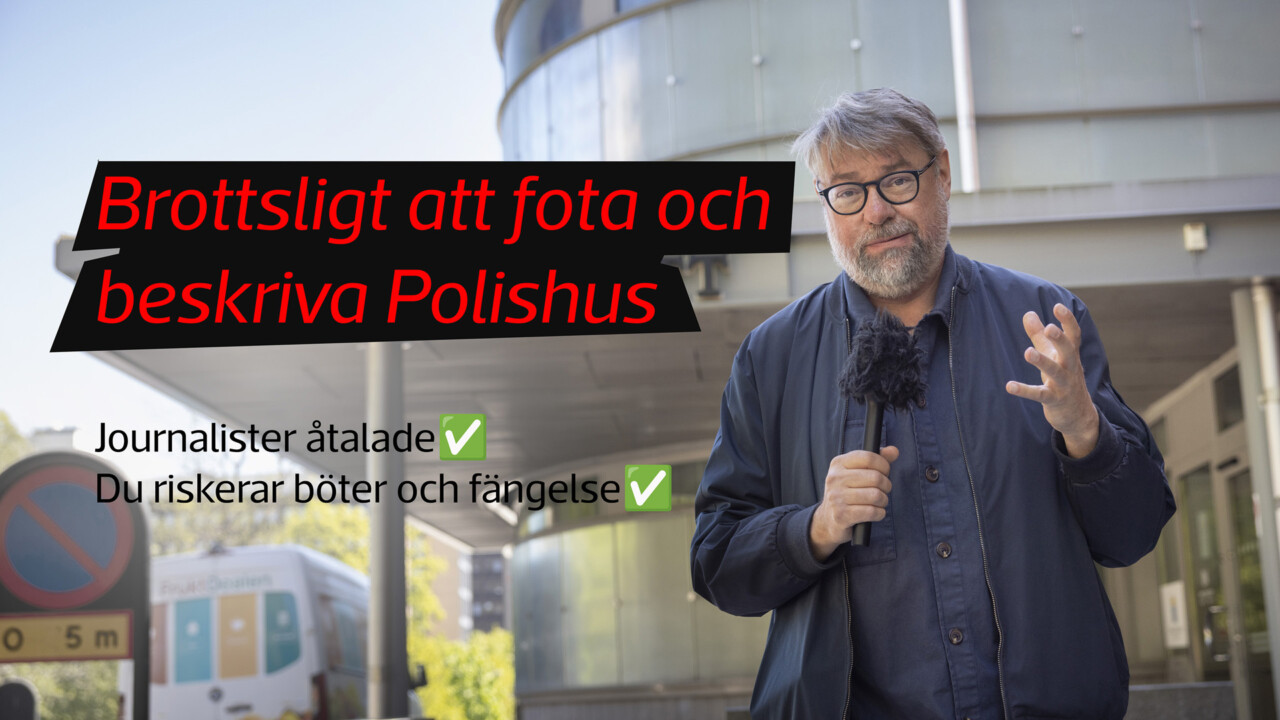

Journalisten berättade tidigare i veckan om experter som varnar journalister för nya AI-appar som kan skapa falska bilder.

DNs Linus Larsson berättar att den specifika AI-tekniken det handlar om i det här fallet har utvecklats i ett rasande tempo på kort tid.

Behöver vi vara oroliga?

– Den intressanta frågan är kanske bilden som ett slags sanningsvittne, det här aktualiserades redan när fotot blev digitalt och Photoshop introducerades. Det blev relativt enkelt att manipulera bilder på ett sätt som ser trovärdigt ut, och i och med det fick man redan då omvärdera bilden som sanningsbärare, menar Linus Larsson.

Det betyder inte att fotojournalistik kommer bli mindre relevant framåt, menar han. Däremot är det dags att vi journalister börjar se på bilder som vi redan nu ser på text.

– Om jag skriver att en person sagt en viss sak, eller att någonting har hänt, så är inte det bevisat bara för att jag skriver det i en text.

Som ytterligare exempel tar Linus Larsson upp när norska NRK, via AI-teknik, nyligen skapade en fejkad genrebild av ett elnät för att illustrera en artikel. Som bildbyline skrev de ”Illustration genererat av Midjourney (AI)”. Efter debatt kring ämnet så ersatte NRK AI-bilden med en ”vanlig” genrebild av ett elnät.

– Där kan man fundera på om NRK gjorde fel? Jag tycker nog inte att det behöver vara så fel, men däremot måste man betrakta bilden som en illustration. Oavsett är det en intressant diskussion tycker jag. Man kan också fundera på vad den här nya tekniken kommer innebära för en viss typ av fotografier, som genrebilder.

Att Microsoft vill inkludera en ny AI-app i sitt Office-paket som når miljoner människor. Vad kommer det betyda för oss journalister i vardagen?

– Varje steg som gör tekniken mer tillgänglig gör ju att det kommer bli allt vanligare. Det kanske också gör oss mer medvetna om att bilder kan komma till på olika sätt? Det här behöver inte vara negativt, eller leda till att fler blir lurade, det kan vara precis tvärtom. Att vara på plats som journalist vid en konflikt eller besöka riktiga platser som man rapporterar om kommer nog bli än viktigare i en sådan utveckling.

Hur kollar du/ni på DN själva äktheten i bilder?

– Jag kan inte minnas att jag ställts inför att en story skulle vara avhängt en bild på det sättet. Det kan säkert ha hänt men jag kan inte minnas det. Ett exempel är väl annars att bilder nu strömmar in från Iran och det är såklart svårt att verifiera var alla kommer ifrån. Men att verifiera är i grunden klassiskt journalistiskt fotarbete, helst ska man ha egna kontakter på plats, kunskap i området och sådana saker. I vissa fall kanske man kan behöva någon form av teknisk analys, ofta kan enkla metoder hjälpa.

Kan du ge några tips till de som inte har så djup kunskap om ämnet men vill verifiera?

– Det klassiska är att göra en omvänd bildsökning på Google, så man kan se om bilden har cirkulerat tidigare. Det är trots allt mycket vanligare än att det handlar om AI-genererade bilder. Sen skulle jag rekommendera klassiskt journalistarbete, kolla upp hur platsen ser ut i verkligheten och om det stämmer med bilden. Vilket väder var det den dagen bilden togs och stämmer det med bilden? Vem har skickat bilden? Är det någon du har anledning att lita på? Sådana saker.